A fadiga das pesquisas é um verdadeiro desafio em nosso setor. Quanto mais longa e repetitiva for uma pesquisa, maior será a probabilidade de os entrevistados desistirem ou, talvez pior, permanecerem, mas fornecerem respostas cada vez mais de baixa qualidade. A nossa próxima iniciativa de IA é uma resposta direta a este problema, com o objetivo de tornar os inquéritos mais curtos e mais inteligentes.

O conceito é simples, mas poderoso: usar IA para realizar análises em tempo real do texto da resposta de um entrevistado a uma pergunta aberta. A IA pode então usar essas informações para preencher previamente as respostas às perguntas subsequentes da pesquisa. Por exemplo, se um entrevistado mencionar que tem dois filhos numa resposta aberta, o inquérito pode preencher automaticamente a resposta a uma pergunta posterior sobre o número de crianças no seu agregado familiar (e ignorar a pergunta). Isso não apenas encurta a pesquisa, mas também cria uma experiência mais personalizada e menos repetitiva para o entrevistado. Nossa equipe tem experimentado essa tecnologia interessante.

Exemplo

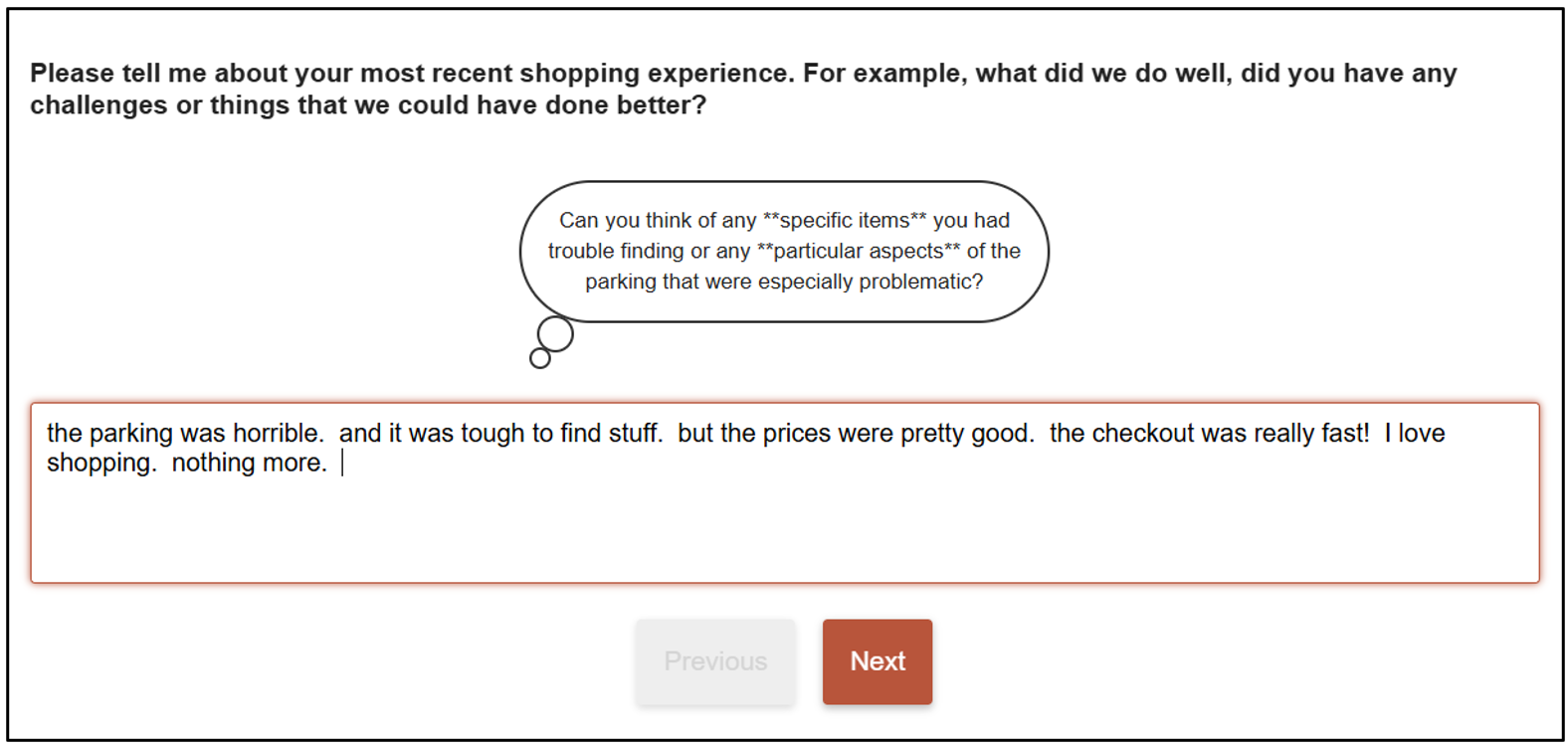

Criamos um exemplo de pesquisa que demonstra tanto a inspiração aberta que lançamos no última postagem do blog e a capacidade de interpretar o texto literal. Na primeira página, você deverá digitar algumas idéias sobre sua experiência de compra recente. Após alguns segundos, você verá prompts com base no texto inserido. Isso funcionará em qualquer idioma.

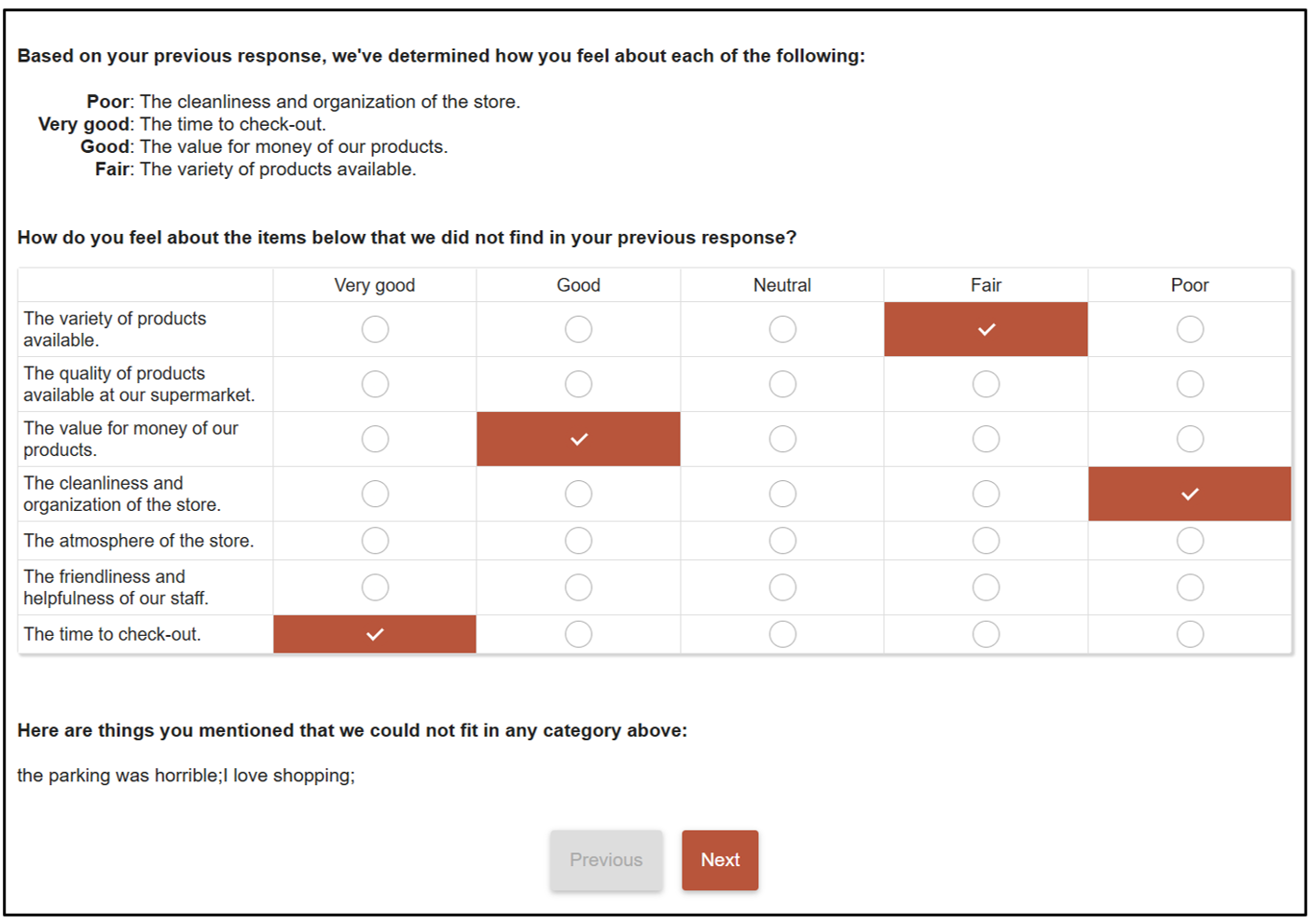

A segunda página interpretará sua resposta aberta e tentará classificar/classificar os atributos predefinidos na pesquisa. Também fornecerá uma lista de afirmações/ideias que não cabem na lista de atributos. Neste ponto, você pode usar qualquer uma dessas informações como lógica em sua pesquisa para fazer (ou NÃO) perguntas adicionais.

No nosso exemplo decidimos mostrar os resultados da classificação AI, pois se trata de uma demonstração. Na realidade, você provavelmente não mostraria isso ao entrevistado e simplesmente usaria as informações para decidir como encaminhar o entrevistado pelo restante da pesquisa da maneira mais inteligente. A maneira mais inteligente, é claro, variará de acordo com o projeto, mas o importante aqui é que, pela primeira vez, você terá a capacidade de interpretar respostas textuais no meio da pesquisa e, em seguida, usar instantaneamente as variáveis codificadas na lógica da sua pesquisa.

O prompt de IA usado na pesquisa de exemplo:

{

"model": "mistralai/mistral-medium-3.1",

"messages": (

{

"role": "user",

"content": "Based on this question \"!!Q1.LongCaption!!\", break up this response \"!!Q1.Value!!\" into unique statements/ideas, format the response into valid json using this model {ratings : {attribute1: insert rating, attribute2: insert rating, attribute3: insert rating },others : { statement1: other text, statement2: other text, statement3: other text, statement4: other text, statement5: other text}}. If there is no answer in the response don't truncate the json, use the value Neutral for the rating. Use the following for the rating scale: \"!!Q2.Responses.Caption!!\" to determine the positive or negative feelings about the following attributes: \"!!LQ2.Responses.Caption!!\". Based on the context of this question: \"!!Q1.LongCaption!!\"... Add the statements/ideas to the others JSON node, but do not include any that are in any way related to these categories: \"!!LQ2.Responses.Caption!!\". Do not provide reasoning or explanation."

}

)

}Observação

Descobrimos que os modelos de IA têm diferentes pontos fortes e fracos. O modelo ‘gpt-4-turbo’ da OpenAI foi melhor em solicitações de conversação aberta. Considerando que o modelo ‘mistral-medium-3.1’ foi melhor na categorização do texto aberto em pensamentos e ideias distintas. Portanto, é provável que você precise de uma variedade de modelos diferentes para diferentes requisitos de “pesquisa inteligente”.

Se você não possui seus próprios provedores privados de IA, ficaremos felizes em conversar com você sobre o uso dos provedores que Askia usa – todos seguros e protegidos do acesso público. Haveria uma pequena taxa de uso para este serviço.